大規模システムを作る前にまず試す

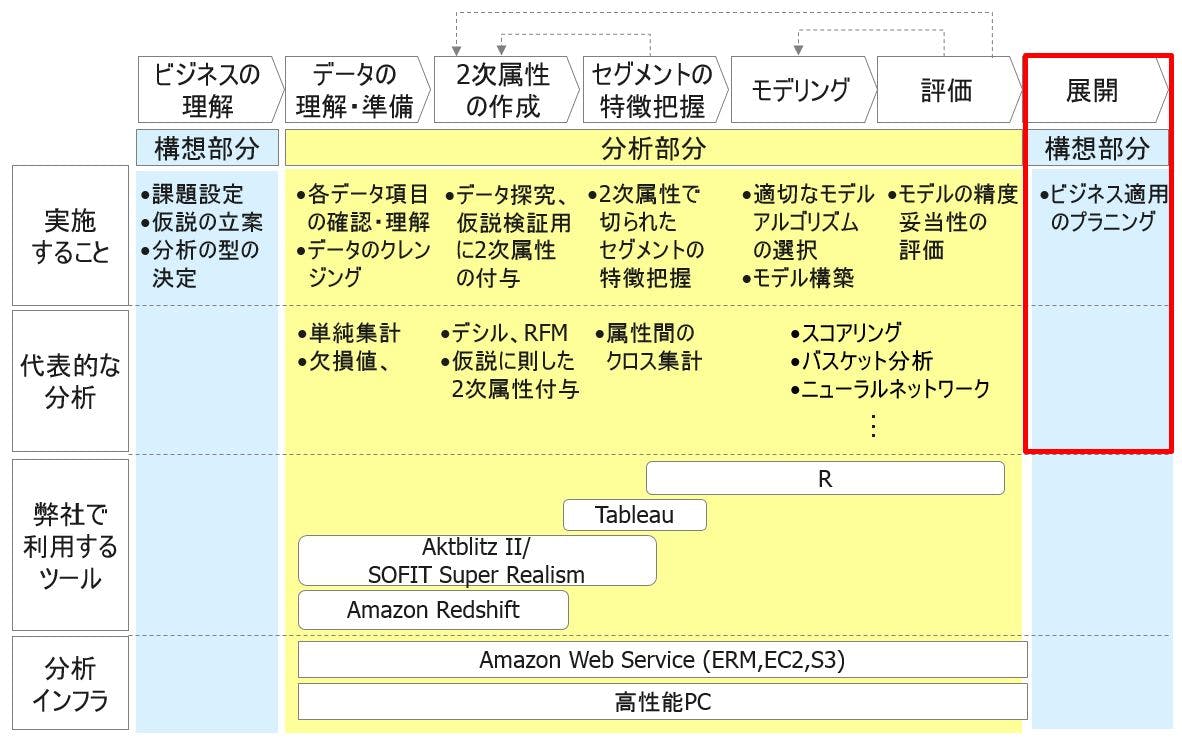

ここまで「ビジネスの理解」「データの準備・理解」「2次属性の作成」「セグメントの特徴把握」というビックデータ分析を試みる際にまず実施すべき一連の流れと、「モデリング」という統計的探索手法をご紹介しました。

本日はこれまでの流れを踏まえて、「ビジネスへの展開」という部分をご説明していきます。ギックスの分析体系の図では以下の赤枠の部分に相当します。

我々は各企業様と分析プロジェクトをご一緒させていただく中で、これまでご説明してきたギックス分析体系に沿った分析を実施していくと、企業様ごとに、自分の会社ではどの部分を深く分析すべきという勘所がわかってきます。

徹底的に2次属性を付けて、クロス集計を回していけばよいということに気づかれ、そこに特化してその結果を経営会議にかけるというルーティーンを作られる企業様もいらっしゃいます。また、ニューラルネットワークを常時回して会員から退会しそうな人を探し出すことが事業インパクト上重要と気づかれる顧客もいらっしゃいます。

これらの気づきは、自社の全データを丸ごと利用した分析にトライしてみて、その中でどの指標やどのモデルが自分たちの事業にとって重要かを把握できたことから生まれています。まず試してみて、その結果から何が重要かを把握するという自然な流れに沿ったものです。そこから必要なもの、定型的なものについてはシステムを構築して、大規模に自動的に回る形にもっていくというのは合点のいくビジネスへの展開だと思います。

ただ、我々がこれまで見てきた分析に関するプロジェクトでは、上記のようなプロセスが踏まれず、最初から大規模なシステムを導入することがありきで動いており、何が必要かはシステムを入れたのちに考えるというケースがありました。あまり信じていただけないかもしれないですが、本当にそんなことが起こっています。

なぜそのようなことが起こるのかというと、原因の一つは、昔は試しに分析してみるという環境が用意できなかったということがあげられるます。コスト的にも、機能的にも試そうにも試せなかった。数年前は、数千万件の大きなデータを扱うためのDWHを構築するのに数億円の投資がかかるというような時代でしたから。ただ、この連載でここまでご説明した通り、ビッグデータでも簡単にPC上扱えるような環境が整ってきている時代です。またこの連載の最後でも触れますが、Amazon Web Servicesをはじめとするクラウド上でまず手軽に実施するということが簡単にできる環境が整ってきます。

分析環境面から見ても、まず試しの試行錯誤の分析を実施する、そのあと重要な部分だけをシステム化するという流れを追えるという環境が整ってきています。その時代の波はぜひ皆さんも乗っかってみてください。まず最初に、自社にとってインパクトのあるものを見つけ出したうえでビジネスへの展開を考えていっていただきたいです。決してシステムを○○億投資して作成しました、このシステムの利用方法はこれから考えます!ということにはならないように。

- PC上で数千万件データを手軽に扱える時代がやってきた

- CRISP-DMをマーケティング領域へ適用させる

- ビジネスへのインパクトを「常に」念頭に置こう

- 2次属性を理解しよう

- クロス集計で「セグメント間の違い」を見出せ

- もう一歩踏み込みたい方は「モデリング」を学ぼう

- 大規模投資の前のトライ&エラーが重要(今回)

- Quick Startのための分析ツールとは

- Quick Startのための分析インフラとは